Erros Comuns a Evitar ao Usar Vozes de Inteligência Artificial

Escrito por

Publicado em

23 de agosto de 2024

Introdução

Incorporar Vozes de IA na sua música é uma ferramenta empolgante e inovadora para músicos e produtores, graças aos avanços na inteligência artificial. Como qualquer nova tecnologia, ela requer alguns ajustes para obter os melhores resultados. Na Kits, processamos conjuntos de dados para criar configurações ideais para treinamento preciso e realista de modelos vocais de IA. Com o tempo, percebi erros comuns que podem prejudicar o desempenho das vozes geradas por IA. Neste artigo, destacarei esses erros e oferecerei dicas sobre como otimizar seus modelos vocais de IA.

Nível e Dinâmica

A voz humana é única, muito parecida com uma impressão digital, com seu próprio timbre e nuance emocional. Cantar é tipicamente uma forma elevada de expressão emocional e pode variar naturalmente em volume. Quando grava vozes, essas variações são frequentemente gerenciadas usando técnicas de microfone e compressores. Cantores experientes podem “auto-comprimir” ajustando a distância em relação ao microfone durante seções mais altas. No entanto, mesmo com essa técnica, geralmente é necessária uma compressão adicional para manter um mix equilibrado.

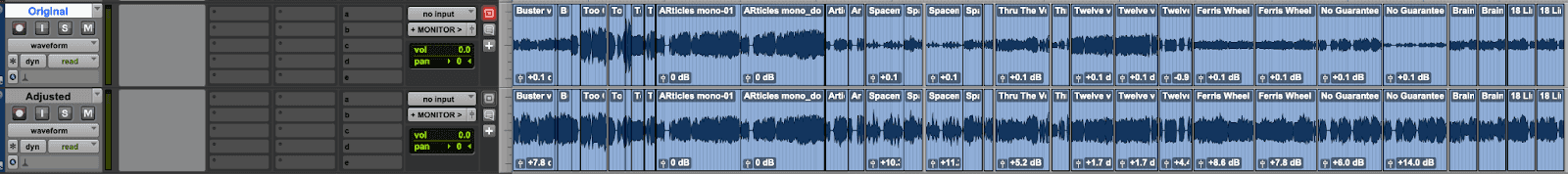

Assim como a compressão natural beneficia as músicas, ela também aprimora o processo de treinamento dos modelos vocais de IA. Na Kits AI, descobrimos que faixas vocais com um intervalo dinâmico controlado produzem melhores resultados na clonagem vocal, especialmente ao usar software avançado para processamento. Minha técnica pessoal para preparar uma voz para treinamento é importar a faixa para meu DAW e usar o ganho do clipe para igualar algumas seções mais extremas antes de aplicar qualquer compressão adicional. Isso garante que o compressor funcione de forma eficiente sem introduzir sons não naturais.

Na imagem abaixo, a faixa superior mostra o conjunto de dados original, enquanto a faixa inferior ilustra meus ajustes de nivelamento:

Ao usar essa abordagem, apenas um leve toque de compressão é necessário. Recomendo não mais do que 3-5 dB de redução de ganho.

Para obter resultados ideais, busque um nível de volume médio de -12 dB com picos não superiores a -6 dB. Isso proporciona uma ótima base para aprendizado de máquina e cria modelos de voz de IA mais realistas.

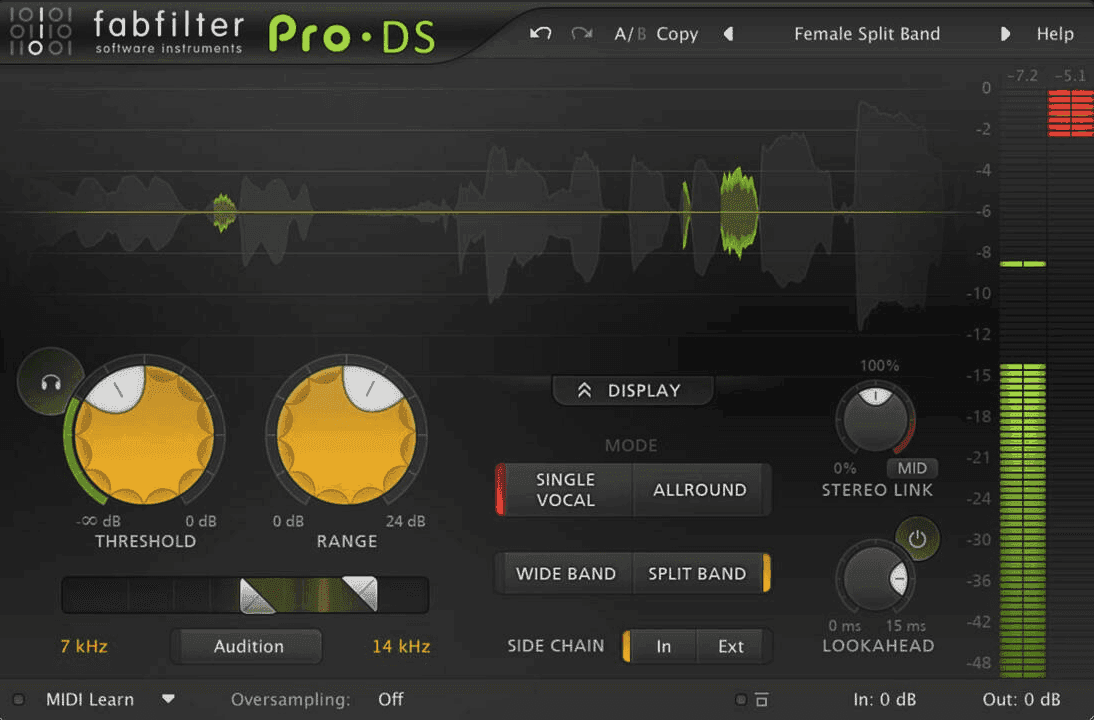

De-esser para Reduzir Sibilância Áspera

A sibilância áspera, causada por consoantes como “s”, “t” e “z”, pode ser distraente e desagradável em gravações vocais. Um de-esser, como o Pro-DS da FabFilter, é essencial para controlar esses sons brilhantes. Isso garante que seu modelo de voz de IA não seja treinado para replicar esses elementos ásperos, resultando em uma saída mais suave e profissional.

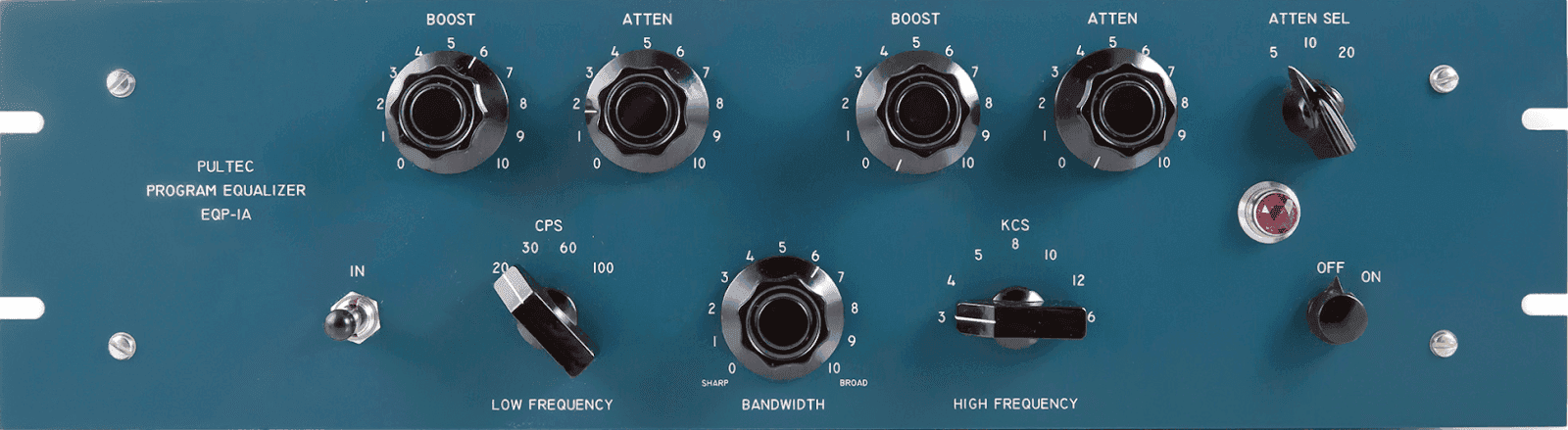

EQ: Equilibrando o Espectro

A equalização (EQ) desempenha um papel crucial na modelagem do som de uma gravação vocal. Embora as configurações específicas de EQ possam variar dependendo do conteúdo musical, um EQ bem equilibrado pode melhorar significativamente a qualidade do seu clone de voz de IA e proporcionar um ótimo ponto de partida para qualquer contexto e gênero que seu modelo de voz de IA irá existir dentro.

Comece com um filtro passa-alta para remover quaisquer frequências graves desnecessárias que não contribuam para o tom vocal. No entanto, tenha cuidado ao passar de 100 Hz, pois isso pode eliminar elementos importantes do timbre vocal.

No outro extremo do espectro, fique atento a quaisquer frequências graves ásperas que podem ser introduzidas por microfones mais acessíveis. Nem todos têm um Neumann vintage para cantar (eu mesmo não tenho). Um filtro passa-baixo pode ajudar a domar essas frequências, normalmente em torno de 20 kHz e acima.

Usar um EQ como o Pultec EQP-1A, conhecido por seu caráter suave e quente, é uma ótima escolha para limpar o ruído de baixa frequência e suavizar os agudos.

Correção de Pitch: Quando e Como Usá-la

Ferramentas de correção de pitch, como a versão gratuita do Antares Auto-Tune, são frequentemente usadas como um efeito na produção musical moderna. No entanto, ao treinar um modelo de voz de IA, recomendo manter as vozes naturais e aplicar a correção de pitch depois que a voz já foi clonada. Essa abordagem mantém o realismo do seu modelo de IA e oferece flexibilidade para projetos futuros que podem exigir um som mais natural.

Variedade Vocal: Expanda Seu Material Fonte

Um dos erros mais comuns no treinamento vocal de IA é a falta de variedade no conjunto de dados vocais. Modelos de aprendizado de máquina só podem ser treinados com o material fornecido, então um conjunto de dados limitado resulta em um modelo vocal limitado. Para explicar, recebi submissões que incluem cantores interpretando uma música repetidamente. Embora possam soar ótimos naquela uma música, eu sei que eles são capazes de atingir notas mais altas e mais baixas, expressando inflexões vocais mais intensas e suaves, tudo isso não será incluído em seu modelo vocal porque o aprendizado de máquina não tem acesso a essas informações adicionais. Isso, por sua vez, fornecerá um caso de uso muito limitado para um modelo de voz de IA.

Para criar vozes de IA versáteis, inclua uma ampla variedade de performances vocais em seu material de treinamento. Isso deve cobrir diferentes tonalidades, expressões emocionais e técnicas vocais, incluindo tanto vozes de peito quanto falsete, para imitar a versatilidade de um artista real. Embora o requisito mínimo seja de 15 minutos de áudio, recomendo utilizar os 30 minutos completos para capturar toda a gama de habilidades do vocalista.

Remova Espaços Vazios

Submissões vocais são frequentemente versões acapella de músicas na íntegra. Como o processo de aprendizado de máquina só se preocupa em analisar uma performance vocal, longos espaços vazios, que podem ser seções instrumentais de uma música completa, são desnecessários e ocupam tempo valioso no conjunto de dados. Para otimizar seu modelo de voz de IA, remova quaisquer seções não vocais e assegure que o áudio seja contínuo, como mostrado no meu exemplo inicial acima. Utilizar essa abordagem maximizará os dados de treinamento e ajudará seu modelo a reter o máximo de realismo possível.

Exporte Seu Áudio Como Mono Verdadeiro

Finalmente, sempre exporte seus stems vocais como faixas mono verdadeiras. Enviar faixas estéreo, mesmo que a gravação tenha sido em mono, dobra os dados percebidos e reduz a quantidade de material utilizável para treinamento. Para obter os melhores resultados de clonagem de voz, maximize a quantidade de material que seu modelo pode ser treinado, transferindo sua faixa vocal para mono antes de enviar para Kits.AI.

Conclusão

Seguindo essas dicas, você pode evitar erros comuns de voz de IA e começar a desbloquear todo o potencial desta ferramenta poderosa. Lembre-se, a IA não é uma ferramenta criativa, é uma ferramenta do criador. Como todas as novas ferramentas e tecnologias emergentes, há uma curva de aprendizado, mas com a abordagem certa, incorporar vozes de IA em sua música pode abrir novas possibilidades que eram uma vez inimagináveis.

-SK

Sam Kearney é um produtor, compositor e designer de som baseado em Evergreen, CO.